目次

はじめに

アメリカで自動運転車の開発を進めてる

企業の一つであるWaymoのエンジニアリング

ディレクタ、Sacha ArnoudさんがMITにて

講義を行ったときの動画をYouTubeで見ました。

www.youtube.com

勉強になることがいろいろ聴けたので、そのメモを

今回の記事としてまとめておこうと思います。

Waymoについて

Waymoについてはこちらを参照下さい。

waymo.com

講義メモ

メイントピック

- WaymoとGoogleによる自動運転の一般的な背景

- 道路環境認識のための機械学習と深層学習の歴史的な用途

- 自動運転に用いられる深層学習の技術概要

- 機械学習に強く依存した産業製品の開発に繋がるもの

アメリカにおける衝突事故のデータ

- 42%がヒューマンエラー

- 40歳以上のアメリカ人の内300万人が盲目あるいは視覚障害者

- 人間一人当たり、年間で42時間を道路交通で浪費している

アリゾナ州での自動運転試験

- 搭乗者は後部座席に座り、どこに向かうかボタンでリクエスト

- その後、自動運転車は自動で目的地に向かい走り出す

- 周辺環境の画像から、道路標識や信号などを抽出して判別

- 道の名前や番号、店の看板や広告なども判別できる

- 夜間の走行でも、信号や他車のライトの点灯を認識可能

- 自転車や歩行者の動きをリアルタイムでトラッキング可能

自動運転車の開発に必要な要素

- 地図構築、位置計測、知覚、環境予測

- 行動予測、動作計画、センサデータ処理

- 車とのインターフェース、シミュレーション

センシングシステム構成

- 車両前方左右にはレーダとレーザ、後方左右にはレーダ

- 屋根の上には全方位監視可能なカメラ、レーダ、レーザ

- これらが知覚の役割を果たし、周辺環境を表現する

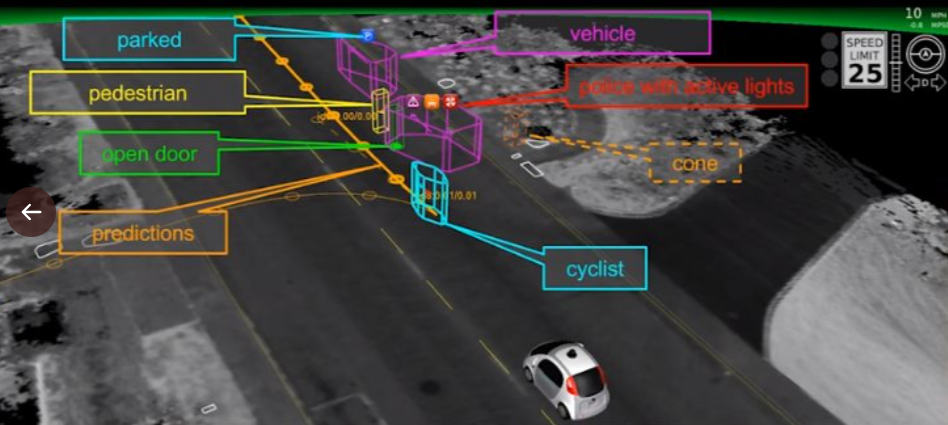

Point Cloudのクラスタリングと行動予測

- レーザのPoint Cloudをクラスタリング

- 自転車、歩行者、他車両などに分類する

- 前方車両のドアの開閉を認識できる

- 車両から人が降りて来るかもしれないと予測

- それを自転車は避けて進むかもしれないと予測

誤認識問題

- 窓ガラスなどへの反射

- 自分の隣を走る車の窓に移った別の車

2台の車がそこに走っていると誤認識する

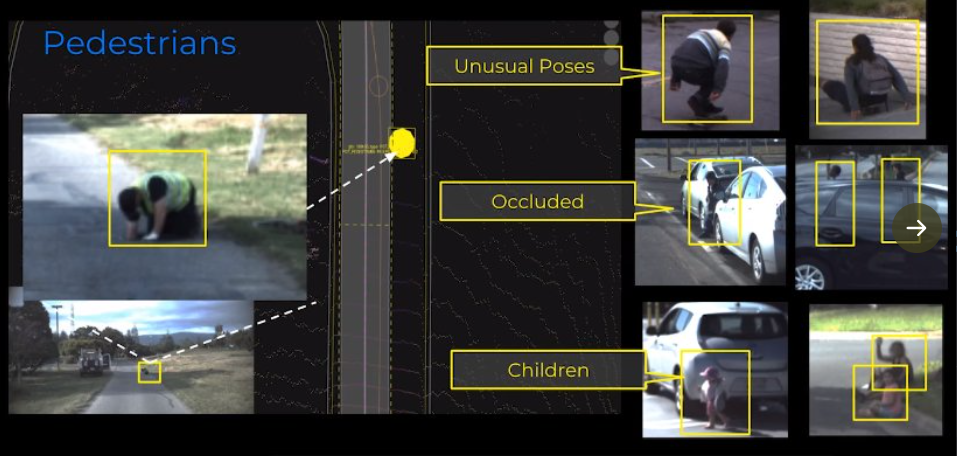

歩行者は様々な姿勢になり、遮蔽されたりする

- 検出して行動を予測することはとても難しい

- 人やマネキンがトラックの荷台に乗って移動するパターン

- それを人だと判断するようなことがあってはいけない

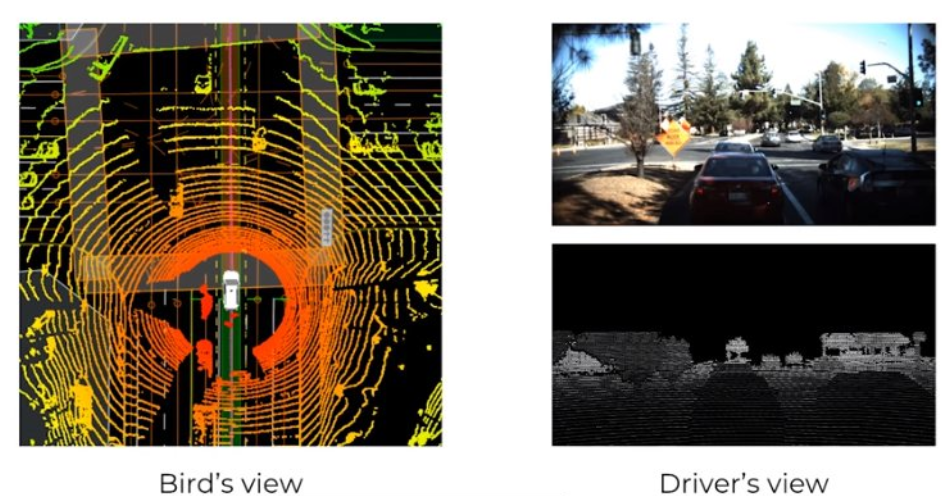

カメラとレーザのセンサフュージョン

- レーザの点群データを2次元平面に投影する

ドライバー視点で取得した画像と組み合わせる

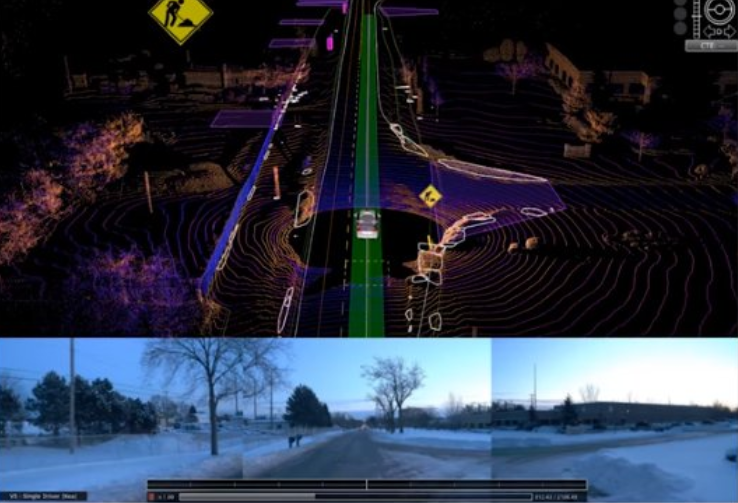

雪のように事前に形状情報を定義できない物体を認識したい

- Smaller Convolutional Networks

- 画像に映る物体を画素単位で分割してクラスタリングする

Semantic Segmentation

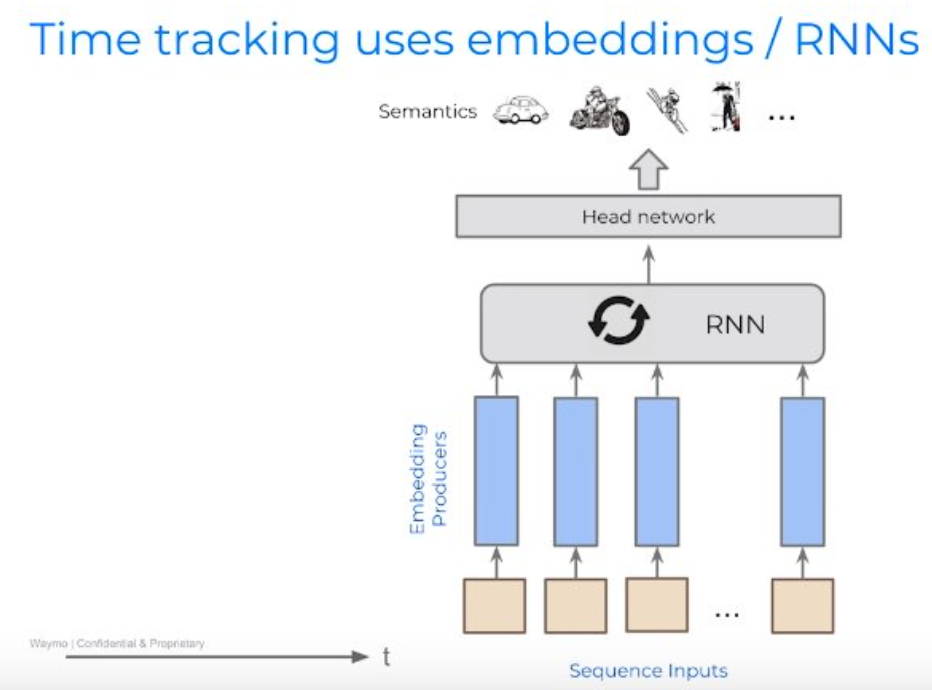

時系列の連続データを用いたベクトル表現

RNN(Recurrent Neural Network)との組み合わせ

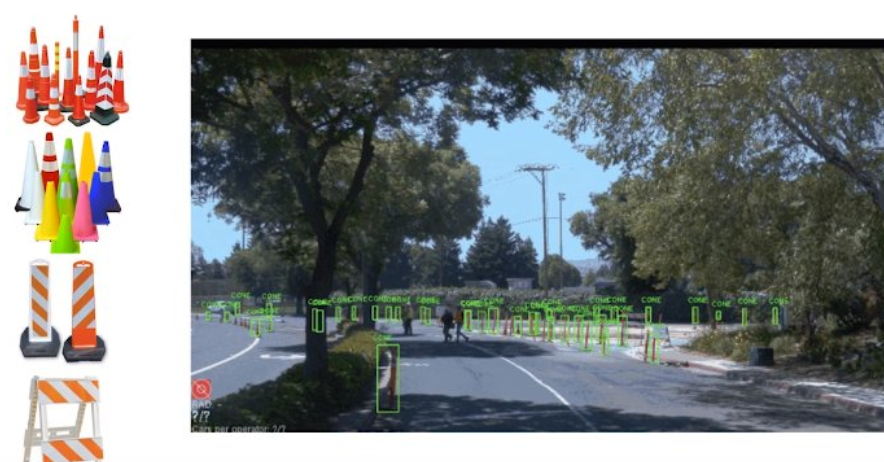

www.procrasist.com走路脇のコーンの検出

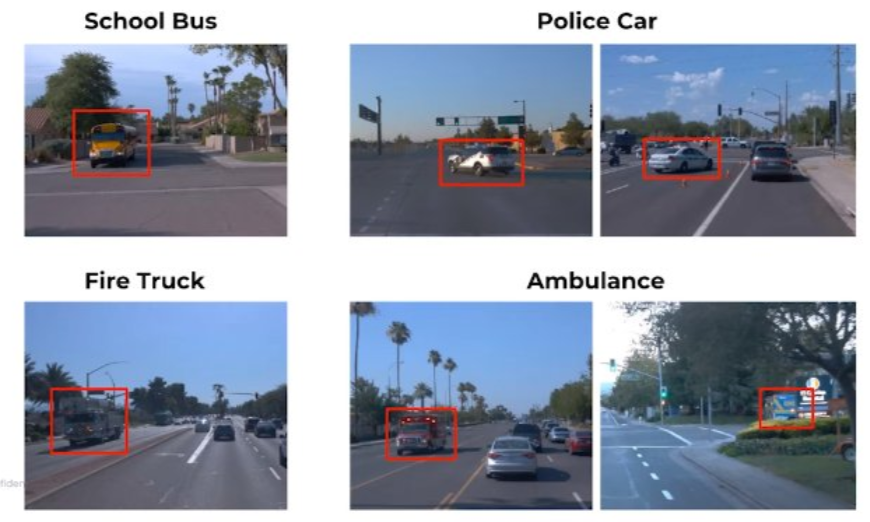

- 通学バス、パトカー、消防車、救急車の分類

- オブジェクトのベクトル表現をディープネットで学習

- GoogleのDNPが開発したwork to Veck

センサの観測範囲内に対象の情報がある場合に有効

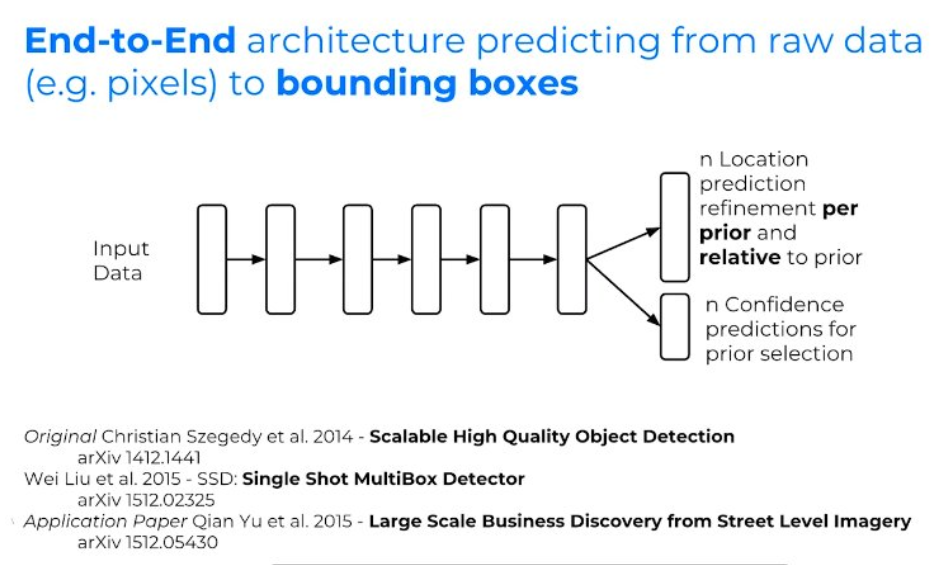

2次元に投影したレーザの点群から形状予測

- それを囲うバウンディングボックスを生成

システムの検証

- 以下の3つを軸にしたシステム検証

Real World Driving, Simulation, Structured Testing

機械学習システムのロバスト性の実機検証

車の進路に別の車を割り込ませての急停車

なかなかリスクの高い試験方法

進路妨害かつ反対車線にも車がいるシチュエーション

- 対向車がいるので車線変更はしない

- 前方の障害物が無くなるのを待つ

今後の課題

- 雪道などでの自動運転

- より複雑な環境の認識や分類

まとめ

機械学習、深層学習をどう活かしているのかが

中心でしたが、後半のシミュレーション環境に

について詳しく聞いてみたかったですね。

実機試験の内容は結構リスキーな印象だけど、

事前のシミュレーションをしっかりやってる

から、そういったリスキーな試験にも臨める

んだろうなと思いました。